Facebook引入数据集和基准 使人工智能更加“以自我为中心”

来源: 2021-10-15 09:33:30

Facebook 今天宣布了 Ego4D,这是一个长期项目,旨在解决“以自我为中心的感知”或第一人称视角的人工智能研究挑战。目标是教人工智能系统像人类一样理解世界并与之互动,而不是像大多数人工智能目前那样以第三人称、无所不知的方式。

Facebook 断言,从第一人称视角理解世界的人工智能可以实现以前不可能实现的增强现实和虚拟现实 (AR/VR) 体验。但是,构成这种 AI 基础的计算机视觉模型历来是从数百万张第三人称拍摄的照片和视频中学习的。Facebook 表示,下一代人工智能系统可能需要从不同类型的数据中学习——从动作中心展示世界的视频——以实现真正以自我为中心的感知。

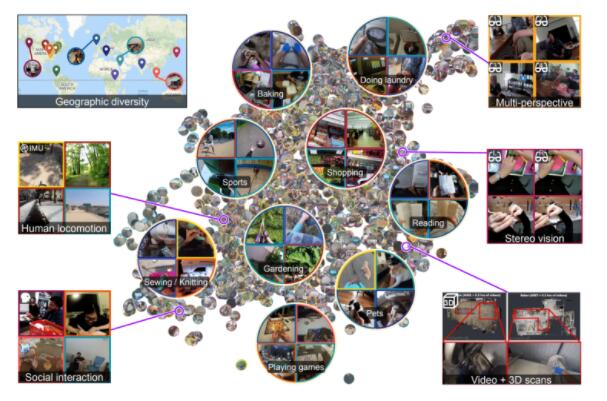

为此,Ego4D 将九个国家的大学和实验室联合起来,收集了超过 2,200 小时的第一人称视频,其中包含来自 73 个城市的 700 多名参与者的日常生活。Facebook 通过向每所参与大学提供学术资助来资助该项目。作为这项工作的补充,来自 Facebook Reality Labs(Facebook 的 AR 和 VR 研究部门)的研究人员使用Vuzix Blade 智能眼镜在研究实验室的分阶段环境中额外收集了 400 小时的第一人称视频数据。

收集数据

Facebook 首席研究科学家克里斯汀·格劳曼 (Kristen Grauman) 表示,今天的计算机视觉系统不像人类那样与第一人称和第三人称视角相关联。例如,如果你将计算机视觉系统绑在过山车上,它可能不知道它在看什么——即使它是根据从地面边线显示的数十万张过山车的图像或视频进行训练的。

格劳曼在一份声明中说:“为了让人工智能系统以我们的方式与世界互动,人工智能领域需要发展到一种全新的第一人称感知范式。”“这意味着在实时运动、交互和多感官观察的背景下,教人工智能通过人眼理解日常生活活动。”

通过这种方式,Ego4D 旨在解决与具身AI相关的挑战,该领域旨在开发具有物理或虚拟化身的 AI 系统,如机器人。具身人工智能的概念借鉴了具身认知,即心理学的许多特征——人类或其他——是由有机体整个身体的各个方面塑造的理论。通过将这种逻辑应用于人工智能,研究人员希望提高人工智能系统的性能,如聊天机器人、机器人、自动驾驶汽车,甚至与环境、人和其他人工智能交互的智能眼镜。

Ego4D 在合作大学招募团队,向研究参与者分发现成的、头戴式摄像机(包括GoPros、ZShades 和 WeeViews)和其他可穿戴传感器,以便他们捕捉日常生活的第一人称无脚本视频.这些大学包括:

布里斯托大学

佐治亚理工学院

卡内基·梅隆大学

印第安纳大学

国际信息技术学院

阿卜杜拉国王科技大学

明尼苏达大学

新加坡国立大学

东京大学

卡塔尼亚大学

洛斯安第斯大学

这些团队让参与者录制了大约 8 分钟的日常场景片段,例如杂货店购物、烹饪、玩游戏时交谈以及与家人和朋友进行集体活动。Ego4D 捕捉相机佩戴者在特定环境中选择注视的位置、他们用手(以及他们面前的物体)做了什么,以及他们如何从以自我为中心的角度与他人互动。

一些镜头与 3D 扫描、惯性测量单元的运动数据和眼动追踪配对。Facebook 表示,这些数据在三步过程中进行了去识别化处理,包括对所有视频文件的人工审查、自动审查和对自动模糊处理的人工审查——但同意分享其音频和未模糊面孔的参与者除外。

潜在偏差

在计算机视觉数据集中,糟糕的表示可能会导致危害,特别是考虑到 AI 领域通常缺乏对偏差的明确描述。之前的研究发现ImageNet和 OpenImages 这两个大型公开可用的图像数据集以美国和欧洲为中心,对种族、民族、性别、体重等方面的人类偏见进行编码。在这些数据集上训练的模型在来自全球南方国家的图像上表现更差.例如,与来自美国的新郎图像相比,来自埃塞俄比亚和巴基斯坦的新郎图像分类精度较低。由于“婚礼”或“香料”等词语的图像在截然不同的文化中呈现方式,当来自全球南方时,物体识别系统可能无法对其中的许多物体进行分类。

科技巨头历来都将有缺陷的模型部署到生产中。例如,Zoom 的虚拟背景和Twitter 的自动照片裁剪工具已被证明不喜欢肤色较深的人。谷歌照片曾经将黑人标记为“大猩猩”,而谷歌的计算机视觉服务 Google Cloud Vision 被发现将一张拿着温度计的黑皮肤人的图像标记为“枪”,同时用浅肤色的人标记了类似的图像。人“电子设备”。最近,一项审计显示 OpenAI 的对比语言图像预训练 (CLIP),一种经过训练以识别图像中的一系列视觉概念并将它们与其名称相关联的 AI 模型,容易对某些性别和年龄范围的人产生偏见。

为了使 Ego4D 多样化,Facebook 表示,参与者是通过来自英国、意大利、印度、日本、沙特阿拉伯、新加坡和美国的不同年龄(97 人超过 50岁)、职业(面包师、木匠、园艺师、机械师等)和性别(45% 为女性,一名被认定为非二元性,三名更愿意不说性别)。该公司还表示,它正在努力扩大该项目,以整合来自其他国家(包括哥伦比亚和卢旺达)的合作伙伴的数据。

但 Facebook 拒绝透露是否考虑了可访问性和存在重大移动问题的用户。残疾人可能有步态或肢体运动模式,这似乎与根据健全人的镜头训练的算法不同。一些残障人士也有与神经问题、精神或情绪障碍或低血糖症相关的交错或口齿不清的言语,如果训练数据集的包容性不够,这些特征可能会导致算法性能更差。

在一篇描述 Ego4D 的论文中,Facebook 研究人员和其他贡献者承认 Ego4D 数据集中存在偏见。他们写道,这些地点距离完全覆盖全球还有很长的路要走,而相机佩戴者通常位于城市或大学城地区。此外,大流行导致了烹饪、清洁和手工艺等“留在家里的场景”的充足镜头,公共活动中的视频更有限。此外,由于电池寿命禁止整天拍摄,Ego4D 中的视频往往包含参与者一天中更多“活跃”的部分。

基准

除了数据集,Ego4D 还引入了新的任务研究基准,Grauman 认为这与数据收集同等重要。“这个项目的一个重要里程碑是提炼出具有智能的以自我为中心的感知意味着什么,”她说。“[这是]我们回忆过去、预测未来以及与人和物体互动的地方。”

基准包括:

情景记忆:人工智能可以通过检索过去视频中的关键时刻来回答自由形式的问题并扩展个人记忆。为此,模型必须在过去的视频帧中定位对查询的响应——并且在相关时,进一步提供环境中的 3D 空间方向。

预测:人工智能可以了解相机佩戴者的行为可能如何影响世界的未来状态,比如人可能移动的位置以及他们可能触摸的物体。预测行动不仅需要认识到已经发生的事情,还需要展望未来以预测下一步行动。

手-对象交互:学习手如何与对象交互对于指导和指导日常任务至关重要。AI 必须检测第一人称的人与物体的交互,识别抓取,并检测物体状态的变化。这种推动力也受到机器人学习的推动,机器人可以通过视频中观察到的人们的经验间接获得经验。

视听分类:人类使用声音来了解世界并识别谁说了什么以及什么时候说的。未来的人工智能也可以。

社交互动:除了识别视觉和声音线索外,理解社交互动是任何智能 AI 助手的核心。具有社交智能的 AI 将了解谁在对谁说话,谁在关注谁。

构建这些基准需要用标签注释 Ego4D 数据集。标签——人工智能模型从中学习数据关系的注释——也带有不平等的标志。众包标签工作的一个主要场所是 Amazon Mechanical Turk,但估计不到 2% 的 Mechanical Turk 工人来自全球南方,其中绝大多数来自美国和印度。

就 Facebook 而言,它表示它利用了第三方注释者,他们被指示观看一个五分钟的剪辑,总结它,然后重新观看它,停下来写下关于相机佩戴者所做的事情的句子。该公司声称收集了“各种各样”的标签类型,包括描述相机佩戴者活动的叙述、物体和动作的空间和时间标签,以及多模态语音转录。总共转录了数千小时的视频并编译了数百万条注释,采样标准涵盖了来自联盟合作伙伴的视频数据。

“Ego4D 注释是由非洲两个地点的众包工作人员完成的。这意味着至少会有一些微妙的方式使基于语言的叙述偏向于他们当地的单词选择,”Ego4D 研究人员在论文中写道。

未来的步骤

现在还为时尚早,但 Facebook 表示,它正在开发受助理启发的研究原型,通过利用植根于物理环境的知识,可以更好地了解周围的世界。“人工智能不仅会开始更好地了解周围的世界,而且有朝一日可以在个人层面进行个性化——它可以知道你最喜欢的咖啡杯或指导你下一次家庭旅行的行程,”格劳曼说。

Facebook 表示,在未来几个月内,Ego4D 大学联盟将发布他们的数据。明年初,该公司计划发起一项挑战,邀请研究人员开发能够理解日常活动第一人称视角的人工智能。

这些努力恰逢 Facebook 的 VR 社交网络Facebook Horizon上周更名为 Horizon Worlds。通过仍处于封闭测试阶段的地平线世界,Facebook 旨在为开发人员提供可用的创建工具,以便他们能够设计出与Rec Room、微软拥有的AltSpace和VRChat等竞争对手应用程序相当的环境。Ego4D 如果成功实现其目标,可以让 Facebook 在利润丰厚的市场中占据一席之地——Rec Room 和 VRChat 尽管没有收入,但估值已达 10 亿美元。

“最终——至少就目前而言——这只是一个非常干净的大型数据集。因此,孤立地看,它并不是特别引人注目或有趣。但这确实意味着对‘以自我为中心’人工智能的未来进行大量投资,以及从第一人称视角记录我们生活的相机的想法,”玛丽皇后大学人工智能研究员迈克库克通过电子邮件告诉 VentureBeat。“我想我主要认为这实际上并没有解决人工智能中的紧迫挑战或问题……除非你是一家想要销售可穿戴相机的大型科技公司。它确实告诉你更多关于 Facebook 未来计划的信息,但是......仅仅因为他们向它注入资金并不意味着它一定会变得重要。”

除了以自我为中心的视角感知 AI、高质量图形和虚拟形象系统之外,Facebook 对“元宇宙”(游戏和娱乐的 VR 世界)的愿景还得到了其 Quest VR 耳机和即将推出的 AR 眼镜的支持。就后者而言,社交网络最近推出了Ray-Ban Stories,这是一款与 Ray-Ban 合作开发的智能眼镜,可通过内置摄像头和麦克风拍摄照片和视频。Facebook 继续改进从Ctrl-labs获得的技术,Ctrl-labs是一家总部位于纽约的初创公司,开发了一种腕带,可将神经肌肉信号转换为机器可解释的命令。

然而,由于技术和政治挑战,Facebook 对元宇宙愿景的进展已经放缓。

首席执行官马克扎克伯格最近将 AR 眼镜称为“十年来最艰巨的技术挑战之一”,类似于“在眼镜框架中安装超级计算机”。Ctrl-labs 的负责人 Andrew Bosworth 承认,它的技术离消费者还有“几年的距离”,而 Facebook 的 VR 头显尚未克服困扰整个行业的限制,如图像模糊、虚拟现实病和“屏幕门效应”。

同样不清楚的是,内部产品放缓可能对 Facebook 与元节相关的努力产生的影响。上周,《华尔街日报》报道称,由于与显示其平台危害的内部文件相关的文章和听证会,Facebook 最近几天推迟了产品的推出。根据这篇文章,该公司的一个团队正在审查所有内部研究,这些研究如果公开可能会损害 Facebook 的形象,并进行“声誉评估”以检查 Facebook 可能会如何受到批评。

为了避免对其 VR 和 AR 计划的批评,Facebook 表示正在征集研究提案,以了解如何使社交 VR 更安全,并探索 AR 和 VR 可能对旁观者(尤其是代表性不足的社区)产生的影响。该公司还表示,它不打算公开 Ego4D,而是要求研究人员寻求“限时”访问数据,以审查并同意每个 Ego4D 合作伙伴的许可条款。最后,Facebook 表示它限制了数据集中图像的使用,阻止了对爆头算法的训练。

相关文章

猜你喜欢

今日头条

图文推荐

精彩文章

随机推荐