算法成为决策缺陷替罪羊:斯坦福大学疫苗事件或是“未来预演”

来源:新浪科技 2020-12-25 14:48:25

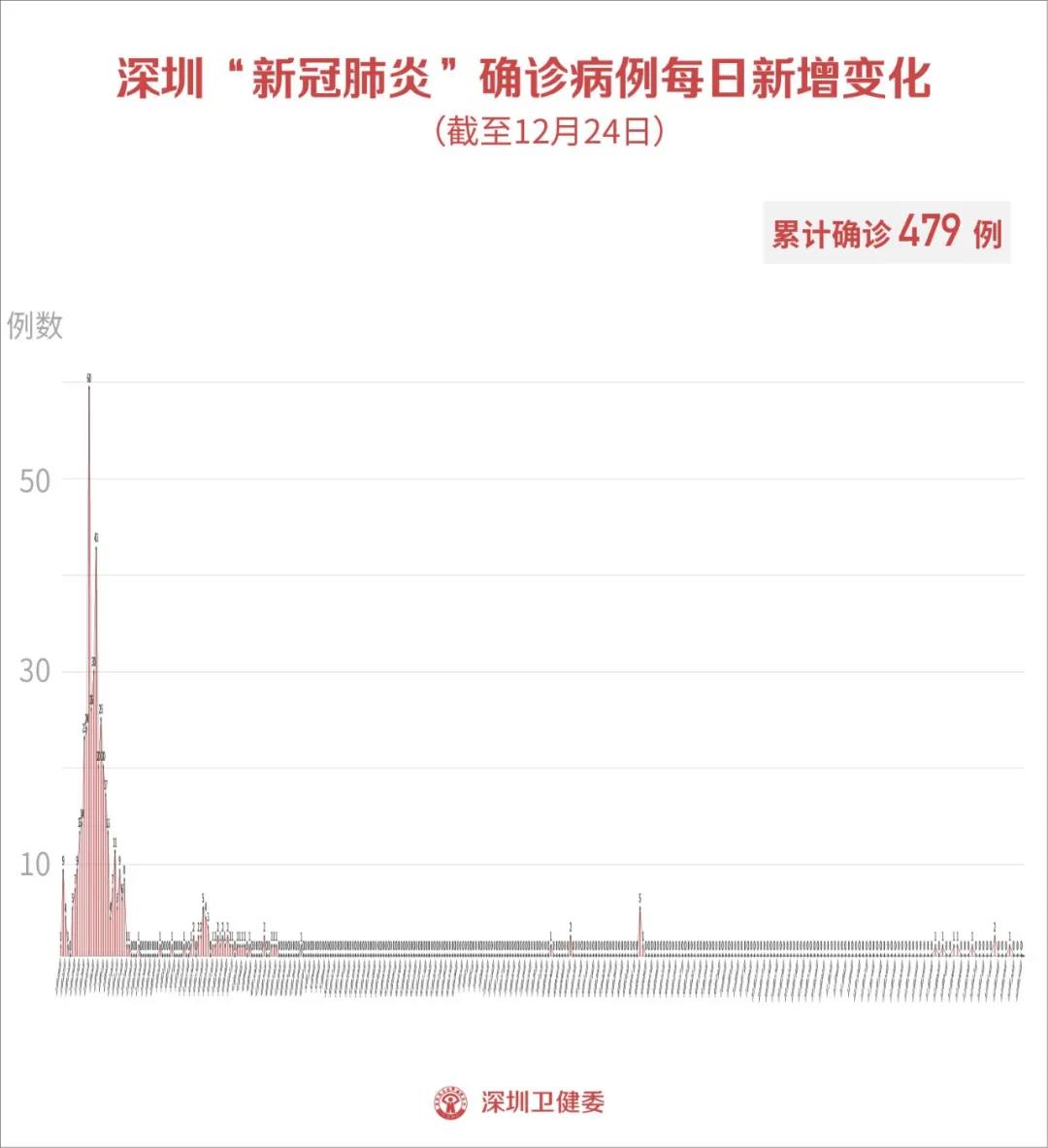

随着新冠肺炎疫苗在全美范围内逐步接种,关于谁先接种疫苗的冲突日渐加剧。面对这种情况,在决策过程中使用的算法如何保持透明度就显得至关重要。

当加州帕罗奥尔托的斯坦福大学医学中心(Stanford Health Care)的一线员工在筛选过程中遭到淘汰,无缘第一批新冠病毒疫苗接种时,该院的官员把责任推到了他们开发的“异常复杂的算法”身上——正是这些算法决定了员工的接种顺序。

但是,与现代互联网所采用的复杂机器学习算法不同,斯坦福大学的系统实际上只是一个基本公式,简单到用Excel电子表格即可胜任。专家对该算法进行详细分析后发现,真正的错误源自设计算法的人:他们并没有根据员工在工作中对病毒的暴露程度来决定接种顺序,而是简单地按照年龄排序。

随着地方政府和工作场所开始推广新冠疫苗,许多人正在转向类似的算法和评分系统,以期以公平、可解释的方式对潜在接种者进行排序。许多公司已经开始向员工索取相关数据,以便通过公式获取清晰的结果。

但是斯坦福的例子却表明,算法未必真能代替考虑周到的政策,而这些简单的数学工具也很容易成为决策缺陷的替罪羊。

尽管斯坦福大学医学中心的官员极力推脱责任,但实际上,这套算法系统只是遵循了决策者制定的规则。而算法设计专家担心,将责任归咎于数学公式,反而会引起公众对疫苗推广过程的不信任,毕竟这些公式归根到底还是由人设计的。

他们认为,真正的问题是武断而又不透明的决策,因为决策者没有在决策过程中与最易受其影响的人展开充分互动。他们认为,如果事先对算法的工作方式进行更加公开透明的讨论,医疗专业人员将对结果更加信任——甚至可能提前展开监督。

他们认为,算法可以发挥重要作用,帮助决策者迅速而公平地将有限数量的疫苗分发给最需要的人。

但是,由于公共卫生方面的指导政策有限,而且要面临众多因素的影响,所以当出现差错时,算法就会成为“背锅侠”。而在可能事关生死的疫苗接种中使用这些算法,只会进一步放大这种影响。

“面对如此庞大的全球规模,不可能单纯凭借人们的直觉和判断来运作。”资深研究科学家凯特·希克斯(Cat Hicks)说,他在非营利性教育组织可汗学院上编写算法并建立预测模型。

她补充说,这些数据“使我们有机会就某件事达成共识,定义证据标准,明确算法符合所有人的想法。但是不能将人排除在外,而是需要进行测试、验证并建立信任,从而加强透明度……我们也可以思考一件事情:哪些人可能会被排除在外?”

随着疫苗供应对象从医院转移到私人雇主,加之人们急切渴望恢复正常生活,疫苗透明度引发的这些冲突可能会产生越来越大的影响。美国疾控中心顾问委员会上周日建议,在满足医护人员的需求后,应该优先让老年人和负责保障基本民生的人员(包括警察、教师和杂货店工人)接种疫苗。

但是算法已经在疫苗的部署决策中发挥了关键作用。一位联邦官员接受媒体采访时表示,本月初在美国乔治·华盛顿大学医院接受疫苗接种的首批民众里,有一些人就是通过算法对他们的年龄、健康状况和感染风险进行评分后筛选出来的。

算法还指导着联邦政府在全美范围的疫苗分配工作。特朗普政府的“空间机战行动”(Operation Warp Speed)就在使用数据挖掘公司Palantir开发的Tiberius系统来分析人口和公共卫生数据,以此确定各州的疫苗分配规模和优先级。事实上,供应沟通混乱和装运延误已经令这项措施的效果大打折扣。

斯坦福大学医学中心的“疫苗接种顺序评分”算法只使用了有限的变量,包括员工的年龄和根据工作岗位估算的新冠肺炎感染率,据此对每位员工进行评分并确定他们的排队顺序。65岁及以上人员或25岁及以下人员可获得0.5分的奖励。

但是,一些算法设计师说,问题在于分数计算方式。一位65岁的居家办公员工,会纯粹因为年龄而增加1.15分。而如果某位员工的同事中有一半人的新冠肺炎病毒检测都呈阳性,他却依然只能增加0.5分。

计分系统的这一缺陷使住院医师感到沮丧和困惑,因为他们每天都会看到居家办公的高层行政人员和医生,先于奋战在病房里的一线医生接种疫苗。在该院排名前5000的接种者中,只有7名住院医师。

与更复杂的算法不同,斯坦福的分数似乎没有为更重要的因素附加额外的“权重”,导致年龄等参数过度扭曲结果。但问题还不止于此:一些住院医师表示,因为他们在医院的多个区域工作,无法指定一个部门,导致得分降低,排名进一步靠后。

当数十名住院医师和其他医务人员涌入斯坦福大学医学中心抗议时,该院的一名主任为医院辩护称,伦理学家和传染病专家花费了数周时间,试图开发一套公平的系统,但是“异常复杂的算法显然没发挥作用”。在现场视频中,可以听到一些抗议者对算法的咒骂。

该院官员在发给儿科住院医师和工作人员的电子邮件中承认斯坦福的疫苗算法未能优先考虑住院医师,但也承诺不会再发生这种情况。

此后,斯坦福大学医学院在一份声明中表示,该院对疫苗分配计划中的错误承担“全部责任”,并将迅速采取行动,为一线员工提供疫苗接种。(斯坦福并不是唯一一家引发不满的医院:圣路易斯的巴恩斯犹太医院的一线护士已经开始请愿,他们批评该医院按照年龄而不是暴露风险来制定疫苗接种顺序。该院管理人员表示,他们只是听从了联邦政府的指导。)

算法是一个很花哨的词汇,它的本质就是一组简单的规则:它是一个公式,就像配方一样,可以使用数据或其他成分来产生可预测的结果。很多人听到这个词就会想起机器学习软件,从语言翻译到无人驾驶再到人脸识别,当今的许多服务都在使用这种技术。

这些算法可以随着时间的推移,使用基本的人工智能技术完善自己的工作。我们每天都与之互动,因为我们在网上看到的搜索结果和社交媒体帖子的顺序都是由它们来决定的。

不过,这些算法虽然做出了复杂的决定,却并没有向人们确切解释它们是如何决策的——这样的“黑匣子”会令质疑结果的人们感到不安。如果算法的设计方式或吸收的数据存在问题,就有可能导致结果失真,带来灾难性的后果,例如种族偏见、信息错报,甚至导致警察因为错误的面部识别结果而抓错嫌疑人。

大多数数据科学家和人工智能研究人员都表示,唯一的解决方案是提高透明度:如果人们可以看到算法、数据和算力的组合是如何设计的,就有望在事态恶化前发现错误。

但是,由于设计算法的公司希望保护自己的专有内容,或者由于系统过于复杂而无法轻松描述,导致这种透明度难得一见。在某些情况下,算法的结论甚至会决定一个人的生死,但即便如此,人们也只能听到千篇一律的说辞:请相信系统正在照常运行。

评论家担心,将算法用于医疗决策可能会引发危险的后果。去年有研究人员发现,医疗公司Optum的一种医疗算法在无意中“歧视”了黑人患者:与白人患者相比,他们在决定病人是否需要额外护理时降低了黑人患者的排名。该公司的一位发言人回应称:“应该不断审查和完善为这些工具提供支持的预测算法。”

今年夏天,英国学生走上街头抗议一种用于决定大学录取的算法。由于疫情导致考试无法进行,该国的考试监管机构决定根据过去的成绩和校内表现自动对学生进行排名——这在无意间偏向了精英学校的学生,导致没有特权背景的学生处于不利地位。但英国政府在此后不久调整了方式。

布鲁金斯学会的数据科学家兼研究员亚历克斯·恩格勒(Alex Engler)表示,当人们用算法来决定工作录取对象或贷款发放对象时,也会产生与斯坦福大学医学中心的算法类似的挫败感。

这些系统将大量的个人、财务和其他数据输入专门的算法,然后返回结果——在某些情况下,它们可能通过自动化技术令旧有偏见进一步固化。

他说,对于某些公司而言,算法已经成为一种非凡的防御机制:它们可以将控制权收归一个中央决策机构,而不再交给不可预测的员工队伍;此外还能令心存疑虑的评论家无从下手;而且,在必要的时候还可以把算法当做替罪羊来保护员工免受外界责难。

恩格勒说,对于企业而言,此举通常是为了集中权力、节约成本或转嫁责任。“而且作为客户,你的影响力会逐步丧失,因为要审查决策流程将更加困难。”

然而,通过算法识别潜在风险已成为企业、学校和地方政府日益重要的工具。人工智能研究人员表示,在开放的互联网上对算法进行大量测试或验证并不会解决人们的合理的担忧和不信任感。

“如果我们生活在一个繁荣发展,经济上公平公正的社会里,人们可能会相信算法。但事实并非如此。”OpenAI实验室政策主任杰克·克拉克(Jack Clark)周一写道,“我们的社会在使用不透明的系统决定影响人们生活的事情,这对多数人来说都越来越不公平。”

他补充说,斯坦福事件只是“未来的预演”。

相关文章

猜你喜欢

今日头条

图文推荐